Ce texte n’est ni une synthèse académique ni une revue d’études.

Il est né de situations réelles, de documents relus trop vite, de décisions corrigées a posteriori, et de cette évidence simple : l’IA n’est fiable que lorsqu’un humain garde le manche.

Introduction – Le vrai danger n’est pas l’IA, c’est nous

En matière d’intelligence artificielle, de politique et de travail, le risque principal ne vient pas des machines, mais de notre propension très humaine à penser trop vite, à parler sans réfléchir… et parfois à dire n’importe quoi, pour peu que ce soit dans l’air du temps.

Il ne s’agit pas ici d’une réflexion théorique, ni d’un énième avis de surplomb.

Ce texte est le fruit d’un retour d’expérience, construit au fil d’usages réels de l’IA, avec leurs enthousiasmes initiaux, leurs promesses séduisantes… mais aussi leurs dérives très concrètes.

Car sur le terrain, les problèmes apparaissent vite :

biais de première impression (« ça a l’air juste, donc ça l’est »),

perte progressive de vigilance,

hallucinations plausibles,

doublons invisibles,

erreurs bien formulées, donc crédibles,

et parfois de véritables deepfakes involontaires, produits sans intention de tromper, mais sans contrôle réel non plus.

Tous ces écueils ont été rencontrés, observés, puis corrigés dans la pratique.

C’est précisément ce passage obligé — fait d’essais, d’erreurs et de relectures attentives — qui fonde le propos de cet article.

L’IA ne fait que refléter ce que nous lui donnons.

Mais ce reflet peut être trompeur, surtout lors de la première impression, celle qui rassure, qui convainc trop vite, et qui incite à valider sans vérifier.

Le problème commence lorsque nous cessons de relire.

Lorsque nous ne comparons plus.

Lorsque nous ne corrigeons plus l’IA quand elle diverge, extrapole, ou se montre incapable de traiter une règle de trois pourtant élémentaire.

👉 L’IA n’est fiable que lorsqu’elle est pilotée, relue, comparée et constamment remise en question par un humain éveillé.

🎭 IA, politique et esprit critique : remise en scène

🗳️ IA et politique : une vieille mécanique… avec un nouvel outil

Depuis que l’homme a inventé la chaise — pour s’y asseoir et, de là, expliquer fièrement aux autres comment vivre — la politique fonctionne globalement avec trois moteurs, d’ailleurs pas si bien connus que cela :

- 🧠 La naïveté collective, et la manipulation de foules à qui l’on peut parfois tout faire faire

- 🙃 La bêtise naturelle, cette cousine du bon sens qui apparaît dès qu’il prend des vacances — dans certains pays, les « Rouspète-Tout-le-Temps » (RTT) sont même rois

- 🎓 L’intelligence des élites, parfois brillante, parfois totalement déconnectée du terrain, parfois aussi… sans véritable public

Le quatrième invité : l’intelligence artificielle

Depuis peu, un quatrième acteur s’est installé à la table, sans être élu :

👉 l’intelligence artificielle générative

Et il faut être clair sur un point fondamental :

- Elle ne vote pas

- Elle ne manifeste pas

- Elle ne milite pas

- Elle ne croit en rien

👉 Elle calcule. Elle produit. Et, comme un marchand de tapis, elle a tendance à vous en proposer toujours plus… surtout pour flatter votre ego.

L’IA ne crée pas d’idéologie. Elle amplifie celles qui existent déjà. C’est donc à l’humain de savoir dire stop. Car mieux vaut parfois ne pas trop en dire que de dire le mot de trop.

Mais à l’ère des réseaux sociaux, où l’on parle souvent pour se faire plaisir plus que pour réfléchir, savoir se taire — et surtout savoir vérifier — devient un exercice étonnamment difficile.

🔍 IA et esprit critique : le vrai champ de bataille

Là où la situation devient réellement préoccupante, ce n’est donc pas dans la technologie, mais dans l’usage immodéré et sans recul qu’en fait l’humain.

Ce que l’IA fait (en général) très bien :

- Produire des textes convaincants

- Donner des réponses rapides

- Imiter une autorité ou un expert

Ce que l’IA ne fera jamais :

- Vérifier la cohérence morale d’un raisonnement

- Distinguer le vrai du faux par intuition humaine

- Assumer la responsabilité d’une décision

👉 L’IA n’est pas dangereuse en elle-même.

L’abandon de l’esprit critique, lui, l’est.

Lorsque l’on délègue toute sa réflexion à une machine, on ne gagne pas vraiment du temps. On perd du discernement, la capacité à relire, comparer, réfléchir et dire non. Mais il est tellement plus confortable de se laisser porter par le courant… après tout, ça marche tout seul.

💼 IA et monde du travail : outil ou béquille mentale ?

Dans le monde du travail, le même glissement est à l’œuvre.

Utilisée intelligemment, l’IA :

- Accélère certaines tâches

- Aide à structurer des idées

- Soutient l’analyse

Utilisée sans réflexion, elle :

- Standardise la pensée : le discours se formate, se robotise, et les particularités se noient dans la masse

- Affaiblit les compétences : à force de tout déléguer, on ne sait plus faire soi-même

- Crée une illusion de maîtrise : la forme rassure, le fond disparaît, et la capacité à remettre en cause ce qui est écrit s’émousse lentement

👉 Un professionnel qui ne comprend plus ce qu’il produit devient dépendant de l’outil.

Et un outil, par définition, ne protège jamais celui qui ne sait plus s’en passer.

Utiliser l’IA dans un domaine que l’on ne maîtrise pas un minimum — nul besoin d’être prix Nobel — conduit rapidement à l’abîme : incapacité à détecter le faux, à corriger les erreurs, à prendre le recul nécessaire.

Faire aveuglément confiance à l’IA sur des sujets que l’on ne comprend pas, c’est s’exposer à des décisions et à des documents totalement déconnectés de la réalité.

🧭 Conclusion – La responsabilité reste humaine

L’intelligence artificielle n’est bien entendu, ni de droite, ni de gauche. Elle n’est ni morale, ni immorale. Elle est neutre, froide, mathématique.

Elle vous imite. Elle vous flatte. Elle vous rassure souvent dès la première lecture.

Mais elle ne se corrige pas toute seule.

👉 C’est à vous de le faire.

La vraie question en 2026 n’est donc pas :

« Que va faire l’IA ? »

Mais bien :

« Jusqu’où sommes-nous prêts à lui faire confiance… dès la première impression ? »

Car c’est souvent là que tout se joue. Un texte bien écrit, fluide, structuré, qui a l’air juste. Alors on valide. On avance. On produit. Sans toujours relire. Sans comparer. Sans vérifier ce qui, sous une forme convaincante, peut pourtant être approximatif, erroné ou hors-sol.

C’est ainsi que l’on glisse, sans s’en rendre compte, vers une délégation excessive : on ne pilote plus, on accompagne vaguement. On ne décide plus vraiment, on entérine. Et l’on finit par produire encore et encore des documents standardisés, parfois truffés d’erreurs ou de clichés, simplement parce qu’ils inspirent confiance — comme l’a montré récemment un certain rapport très sérieux… sur un domaine pourtant stratégique.

Oui, l’IA est un formidable outil. Oui, elle peut faire gagner un temps précieux, tant qu’on la considère comme un assistant et non comme un remplaçant.

Une aide remarquable, à condition de ne pas en faire une béquille intellectuelle. À condition surtout de garder le manche, de rester attentif aux premières impressions, et de conserver ce réflexe simple mais exigeant : relire, comparer, corriger, parfois dire non.

Et comme souvent en technologie, le progrès n’est pas le problème. Le problème, c’est l’usage que nous en faisons… assis bien confortablement sur notre chaise, pendant que l’autopilote travaille, et que nous regardons défiler le monde sans toujours vérifier la trajectoire.

Au fond, garder le cap n’a rien d’élitiste. Il suffit de rester présent, un peu vigilant, et suffisamment humain pour ne pas confondre une belle première impression avec une vérité durable.

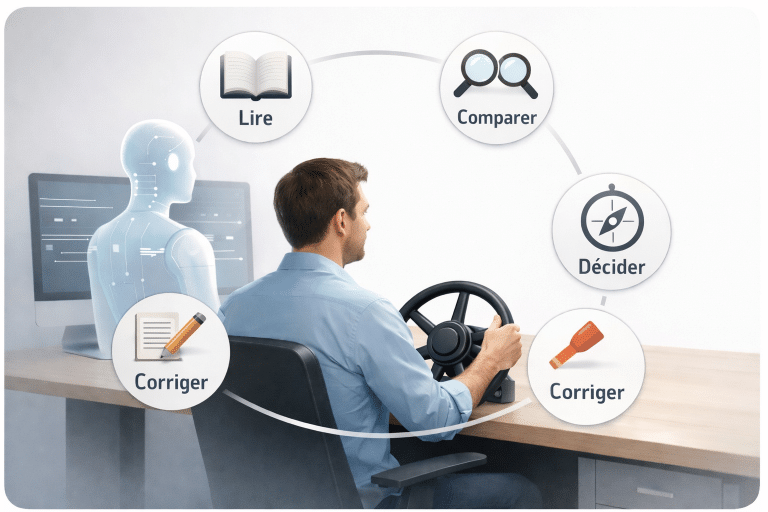

🧭 Le réflexe ACDM en 4 verbes

Face à l’intelligence artificielle, il n’y a pas besoin de jargon ni de diplômes supplémentaires. Il suffit d’un réflexe simple, éprouvé sur le terrain, et toujours valable en 2026 :

- Lire – ne jamais valider un contenu sans l’avoir réellement lu

- Comparer – confronter l’IA à une autre source, un autre point de vue, ou à son expérience

- Corriger – ajuster, reformuler, supprimer ce qui sonne juste mais ne l’est pas

- Décider – assumer la décision finale, sans la déléguer à une machine

Ces quatre verbes ne ralentissent pas le travail. Ils évitent surtout de confondre une bonne première impression avec une vérité solide.

Lire

Prendre le temps de lire vraiment,

pas seulement de survoler.

Comparer

Confronter à d’autres sources,

à son expérience, au réel.

Corriger

Ajuster, reformuler, supprimer

ce qui sonne juste mais ne l’est pas.

Décider

Assumer la décision finale,

sans la déléguer à une machine.

Cette question prolonge d’autres réflexions publiées sur La tête sur le billet autour de la manipulation de l’information et de la responsabilité humaine. Si ces questions vous parlent et que vous les retrouvez parfois, concrètement, dans votre rapport au numérique ou à votre Mac, je propose aussi un accompagnement simple et humain. Les infos sont ici.

Sources et repères

Un bon article d’opinion n’a pas besoin de sources pour exister, mais il gagne beaucoup à montrer qu’il sait où elles se trouvent.

Les réflexions développées dans cet article s’appuient sur des travaux récents, des analyses institutionnelles et des publications de référence consacrées à l’intelligence artificielle, à la désinformation et à leur impact sur la vie démocratique.

- Is the politicization of generative AI inevitable? – Brookings Institution

- The era of AI persuasion in elections is about to begin – MIT Technology Review

- Artificial intelligence and elections – Parlement européen (EPRS)

Ces sources ne dictent pas une conclusion. Elles servent de points d’appui pour nourrir une réflexion critique, qui reste avant tout humaine et assumée.

Publications similaires :

- lettre-informations-aucoeurdumac

- Assistance Apple Mac ligne domicile Genève Lausanne Montreux

- Aide numérique à la recherche d’emploi

- aucoeurdumac page 404

Propulsé par YARPP.